| ← Октябрь 2014 → | ||||||

|

11

|

||||||

|---|---|---|---|---|---|---|

|

13

|

14

|

15

|

||||

|

20

|

22

|

26

|

||||

|

27

|

||||||

За последние 60 дней ни разу не выходила

Сайт рассылки:

http://www.xakep.ru/

Открыта:

09-04-2009

Статистика

0 за неделю

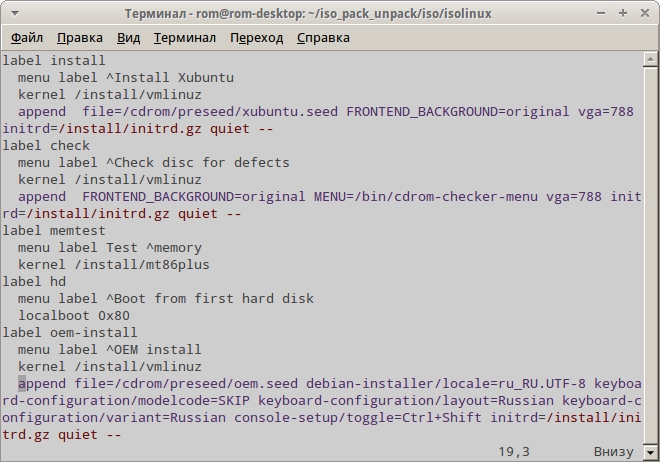

Развертывание различных дистрибутивов Linux в корпоративной среде *

|

| В избранное | ||